Одна з переваг онлайн-курсів — зручність. Вони доступні будь-де й будь-коли — звісно, якщо є підключення до Інтернету. Однак у середньому онлайн-курси завершують не більше 13% слухачів. Причини, з яких люди кидають навчання, різні — втрата інтересу до матеріалу, нестача часу, базових знань. Розробники онлайн-курсів з Гарварду спробували вирішити проблему за допомогою сучасних освітніх технологій і запровадили елементи адаптивного навчання в онлайн-курс Super-Earths and Life.

Як адаптивні елементи в масовому відкритому онлайн-курсі (МВОКу) вплинуть на результати проходження курсу, залученість слухачів та статистику закидання?

Щоб знайти відповіді на ці запитання, Гарвардський університет та розробник освітніх технологій TutorGen додали адаптивні елементи в онлайн-курс Super-Earths and Life.

Адаптивна навчальна система складається з двох частин:

Навчальний алгоритм Bayesian Knowledge Tracing, заснований на роботах англійського математика Томаса Баєса. Він оцінює рівень знань студента.

Адаптивний двигун (adaptive engine) SCALE (Student Centered Adaptive Learning Engine) від компанії TutorGen. Його функція — обирати наступне завдання, яке отримає слухач.

Обидва елементи працюють у режимі реального часу та реагують на відповіді користувачів. Так слухач курсу отримує завдання, які відповідають його поточному рівню знань.

Розробка експерименту

Адаптивні завдання розробили для онлайн-курсу Super-Earths and Life, присвячений пошуку життя поза планетою Земля. Він вимагає базових знань із фізики, астрономії та біології.

Одна з умов впровадження адаптивних елементів — більша кількість навчальних матеріалів. Тому до команди розробників долучився доктор Алессандро Массаротті (Dr. Alessandro Massarotti), який написав практично весь адаптивний контент. Так кількість матеріалів в частинах курсу, де застосовувалися адаптивні елементи, збільшилася майже втричі.

Слухачів онлайн-курсу розділили на дві групи: експериментальну та контрольну. Експериментальна група проходила онлайн-курс з адаптивними завданнями, а контрольна – звичайний МВОК. Розподіл на групи відбувався випадково, під час реєстрації на курс. Обидві групи виконували 16 оцінювань, але в експериментальній групі 4 з 16 оцінювань були адаптивними.

Усі інформаційні компоненти курсу (knowledge components) отримали теги — спеціальні мітки, які співвідносили кожне завдання з окремою навчальною ціллю (learning objective). Адаптивні завдання додатково розподілили за трьома рівнями складності: легкий, середній та складний.

Отже, адаптивні завдання залежали не тільки від успіхів слухачів, але й від змісту пройденого матеріалу. Наприклад, завдання високого рівня складності з’являлися лише після проходження складних тем.

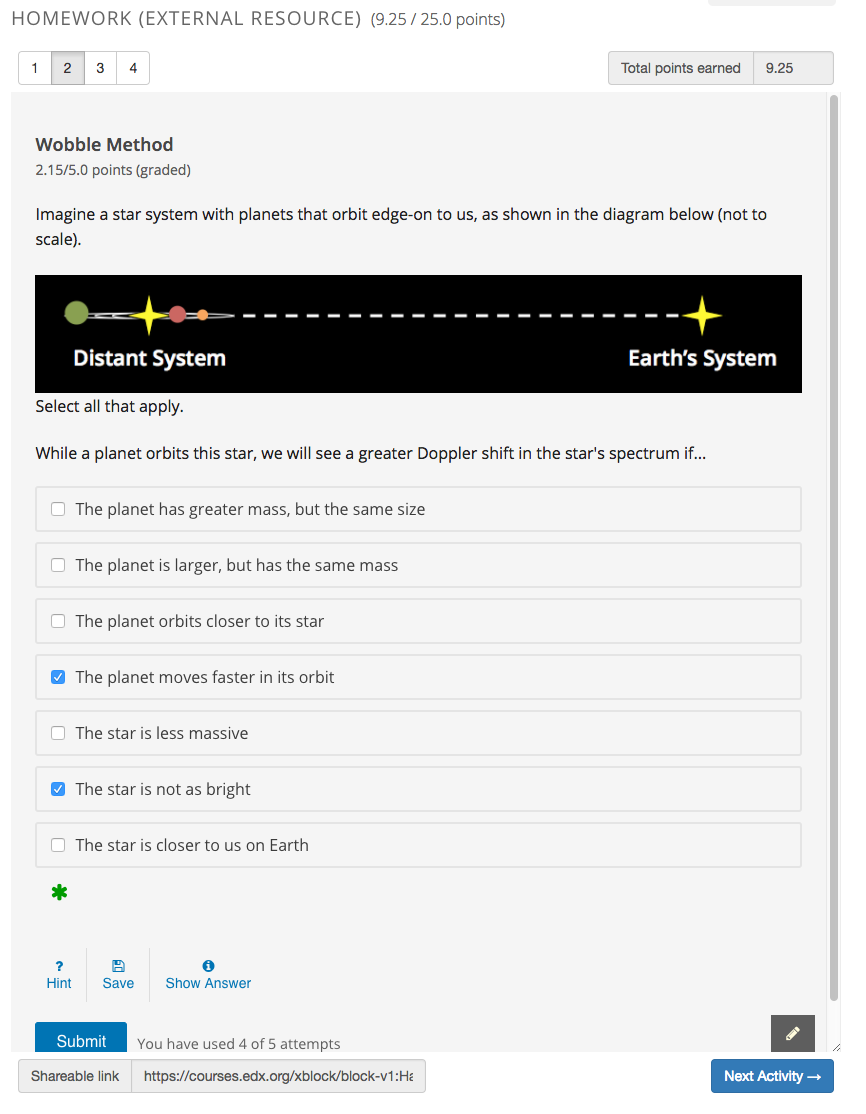

Приклад адаптивного оцінювання в експериментальній групі. Джерело: The Bridge for Adaptivity: Enabling the Use of Adaptive Assessments in edX

У прикладі вище користувач працює над ланцюжком з 4 завдань. Усі завдання не адаптивні. Проте відповіді на цей своєрідний ланцюжок вплинуть на п’яте завдання. Отже, воно адаптивне.

Зверніть увагу, що тестові завдання передбачають певну кількість спроб (вказано біля кнопки Submit). У нашому прикладі спроб 5. Отже, слухач може повернутися до певного завдання в ланцюжку, виконати його по-іншому, і це вплине на п'яте, адаптивне завдання.

Технічна реалізація

Щоб об’єднати платформу онлайн-курів edX, адаптивний двигун SCALE та власне контент курсу, у Гарварді розробили веб-додаток Bridge for Adaptivity (BFA).

BFA сполучається з edX завдяки Learning Tools Interoperability (LTI). LTI — це стандарт, розроблений IMS Global Learning Consortium. Він дозволяє зовнішнім веб-додаткам (наприклад, BFA) взаємодіяти із системами управління навчанням (learning management systems), такими як edX.

Щоб забезпечити адаптивність, у кожне запитання курсу вбудували невеличку програму на мові JavaScript. Після того як студент виконував завдання, програма надсилала його результати BFA. Потім BFA передавав результати адаптивному двигуну SCALE, який вже аналізував їх та видавав наступне запитання.

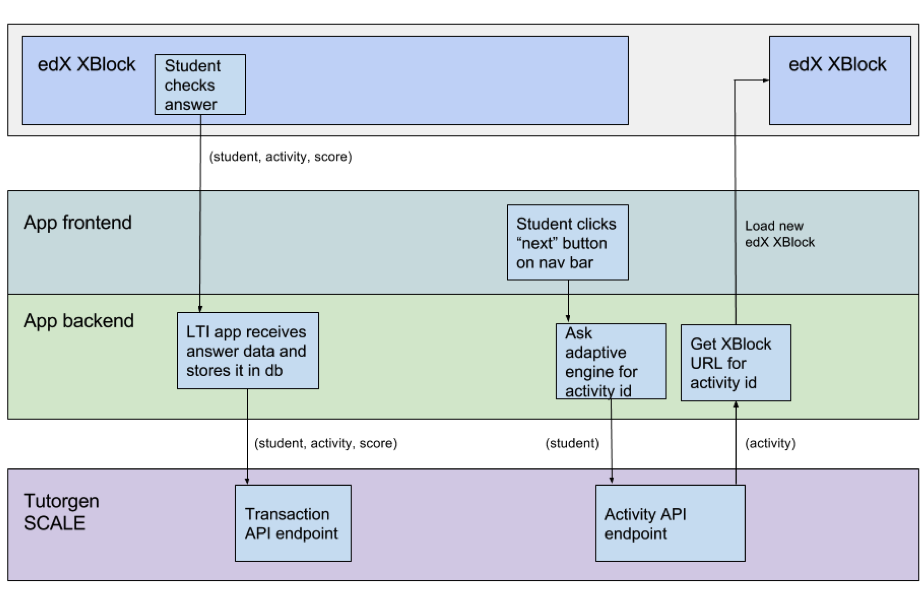

Шлях даних, необхідних для адаптації наступного завдання. Джерело: The Bridge for Adaptivity: Enabling the Use of Adaptive Assessments in edX

Коли слухач онлайн-курсу відповідає на запитання та перевіряє відповідь, інформація через BFA надходить до адаптивного двигуна SCALE. Далі слухач натискає кнопку «наступне запитання», BFA надсилає запит до SCALE щодо рекомендацій саме для цього слухача. SCALE аналізує прогрес користувача й надсилає id (ідентифікатор) обраного завдання до BFA. BFA, у свою чергу, завантажує відповідне запитання на платформі edX.

Результати експерименту

Коли експеримент завершився, контрольна група слухачів налічувала 254 людини, а експериментальна – 264. Враховувалися результати 39 запитань: 12 низької складності, 13 – середньої та 14 – високої.

Дослідників цікавили три показники:

- академічні результати — хто краще засвоїв матеріал;

- який відсоток слухачів закинув курс;

- швидкість виконання завдань.

Щоб оцінити академічні результати слухачів, було проведено два тести – перед курсом та після нього. Вони не враховувалися в підсумковій оцінці за курс, тому їх виконали лише 40% користувачів. Аналіз результатів виявив, що статистично достовірної різниці між кількістю правильних відповідей у контрольної та експериментальної групи немає.

Наявність адаптивних запитань також не вплинула на кількість людей, які закинули курс. Водночас, це свідчить, що адаптивні технології не мають побічних ефектів, адже результати учасників не погіршилися. Хоча, мусимо визнати, і не покращилися.

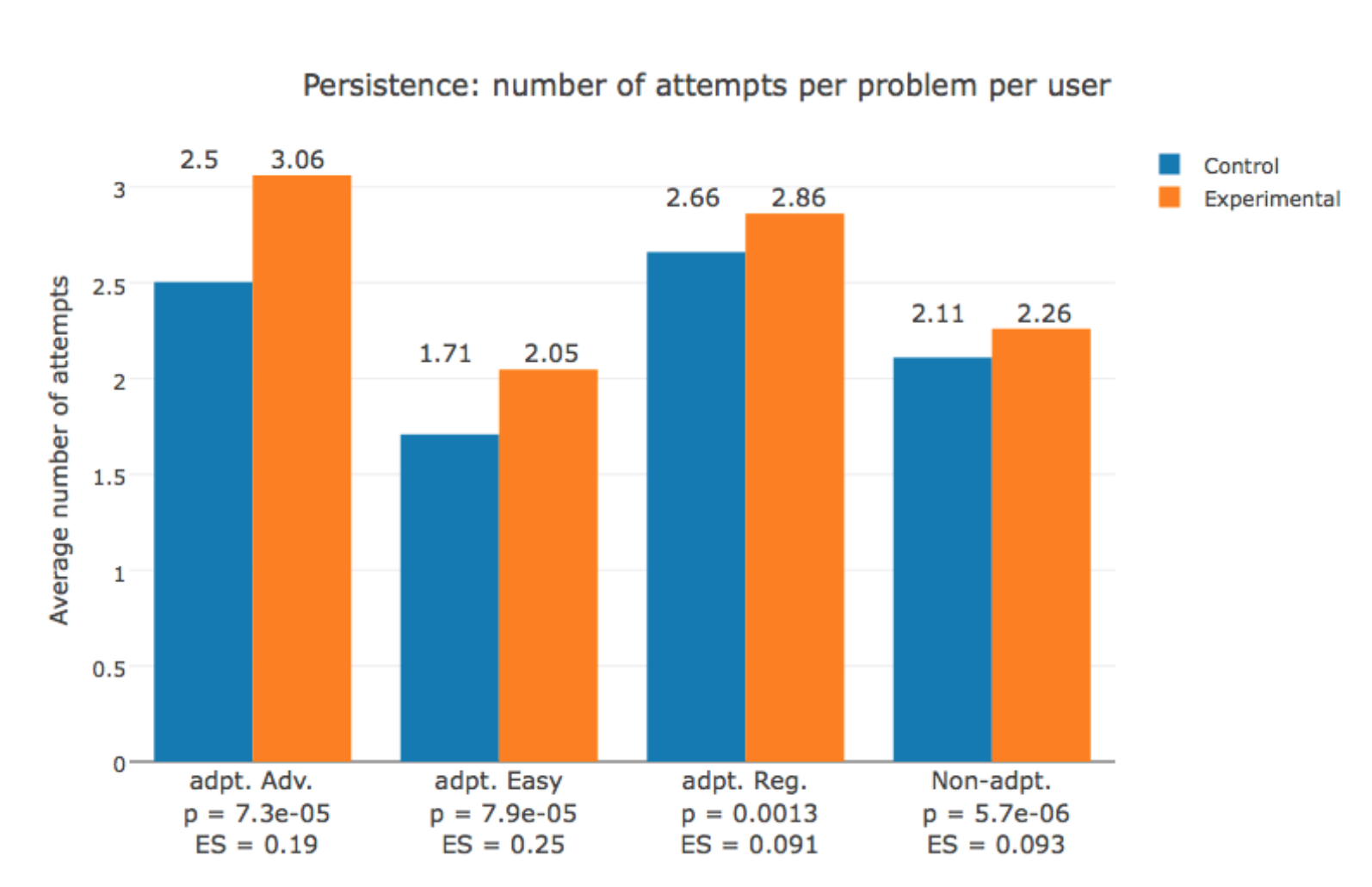

Цікавими виявилися дані, що стосувалися швидкості проходження завдань та кількості спроб. Слухачі з експериментальної групи були наполегливішими: вони використовували більше спроб відповісти на запитання, але водночас виконували менше завдань.

Останні два стовпчики — кількість неадаптивних завдань, які виконували обидві групи. Джерело: Adaptive Assessment Experiment in a HarvardX MOOC

Такі результати дозволяють припустити, що навчання з адаптивним оцінюванням виявилося більш ефективним. Слухачі з експериментальної групи не витрачали час на завдання, які мало або взагалі не впливали на їхні знання. Вони отримували саме ті завдання, які відповідали поточному рівню знань, наполегливіше над ними працювали (про що свідчить більша кількість спроб проходження завдань) та швидше просувалися курсом. Так адаптивне оцінювання допомогло оптимізувати навчальний процес.

Гарвардський університет зазначає, що висновки стосовно впливу адаптивних технологій на академічні результати в онлайн-курсі робити ще зарано, але впроваджувати адаптивні елементи у МВОКи та аналізувати їх вплив — безумовно варто. З оглядом дослідження можна ознайомитися у статті Adaptive Assessment Experiment in a HarvardX MOOC. Більше про технічну реалізацію проекту можна дізнатися у цих чотирьох матеріалах:

The Bridge for Adaptivity: Enabling the Use of Adaptive Assessments in edX.

Авторка матеріалу: Анна Ляшенко, методистка EdEra